一、核心伦理原则体系

确立AI开发和应用必须遵循的根本性伦理准则,作为责任判断的价值基石。

- 以人为本 (Human-centricity): AI系统的设计、开发和部署应以促进人类福祉、尊重人类尊严和权利为首要目标。

- 公平公正与非歧视 (Fairness, Justice, and Non-Discrimination): AI系统应避免产生或加剧不公平的偏见和歧视,努力实现机会和结果的实质公平。

- 可控可信 (Controllability and Trustworthiness): AI系统在其整个生命周期中应保持可控,其行为应可预测、可靠,并能赢得用户和社会的信任。

- 透明度与可解释性 (Transparency and Explainability): AI系统的决策过程和数据使用应尽可能透明,对于关键决策,应提供合理的解释。

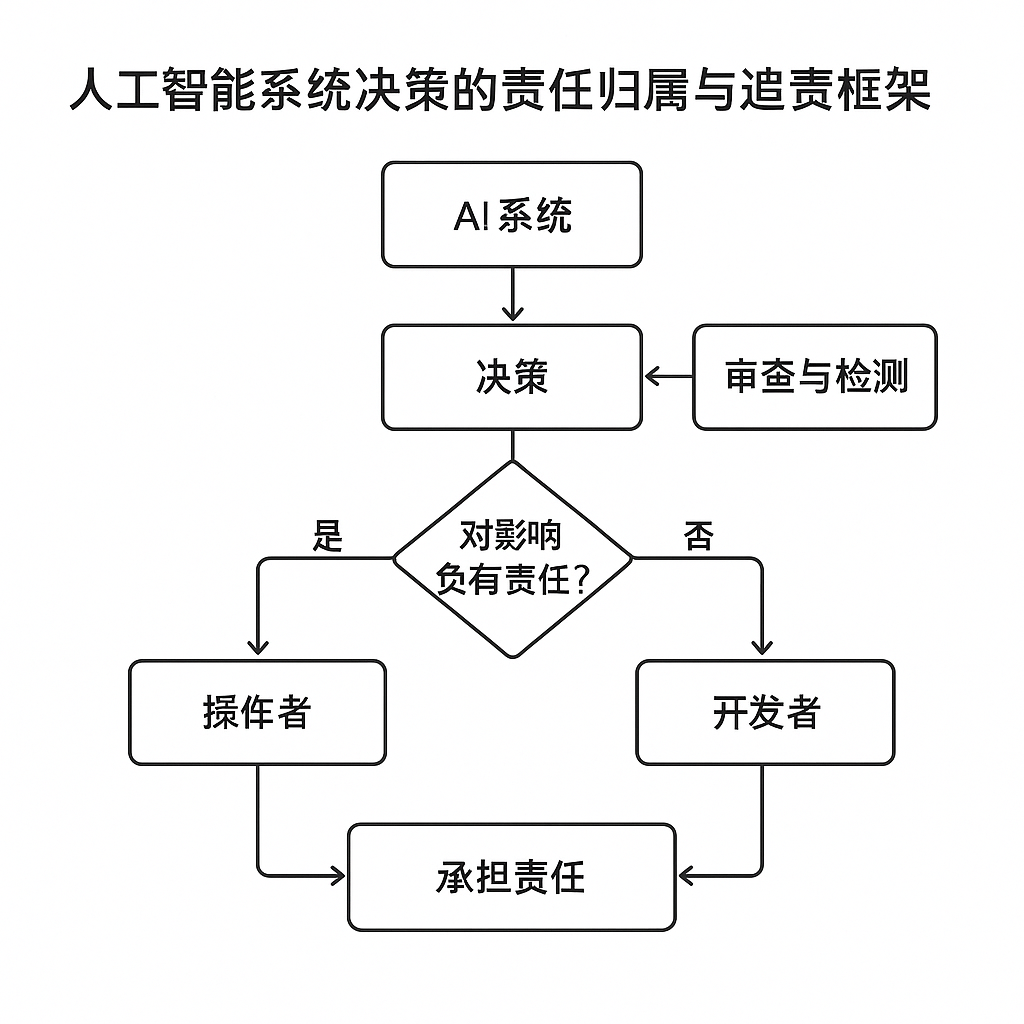

- 问责与责任 (Accountability and Responsibility): 对于AI系统造成的损害或不当决策,必须能够明确责任主体并追究其责任。

- 安全与保障 (Safety and Security): AI系统应在其整个生命周期内保持安全,能够抵御恶意攻击和滥用,保障个人和社会安全。

- 隐私保护 (Privacy Protection): AI系统在数据收集、处理和使用过程中应严格遵守隐私保护原则和法规,尊重个人隐私权。

- 可持续性与社会福祉 (Sustainability and Societal Well-being): AI的发展应促进社会的可持续发展,并增进整体社会福祉。

图表 3.2: AI系统决策责任归属与追责核心伦理原则体系

)

该图展示了指导AI责任框架的核心伦理原则及其相互关系。

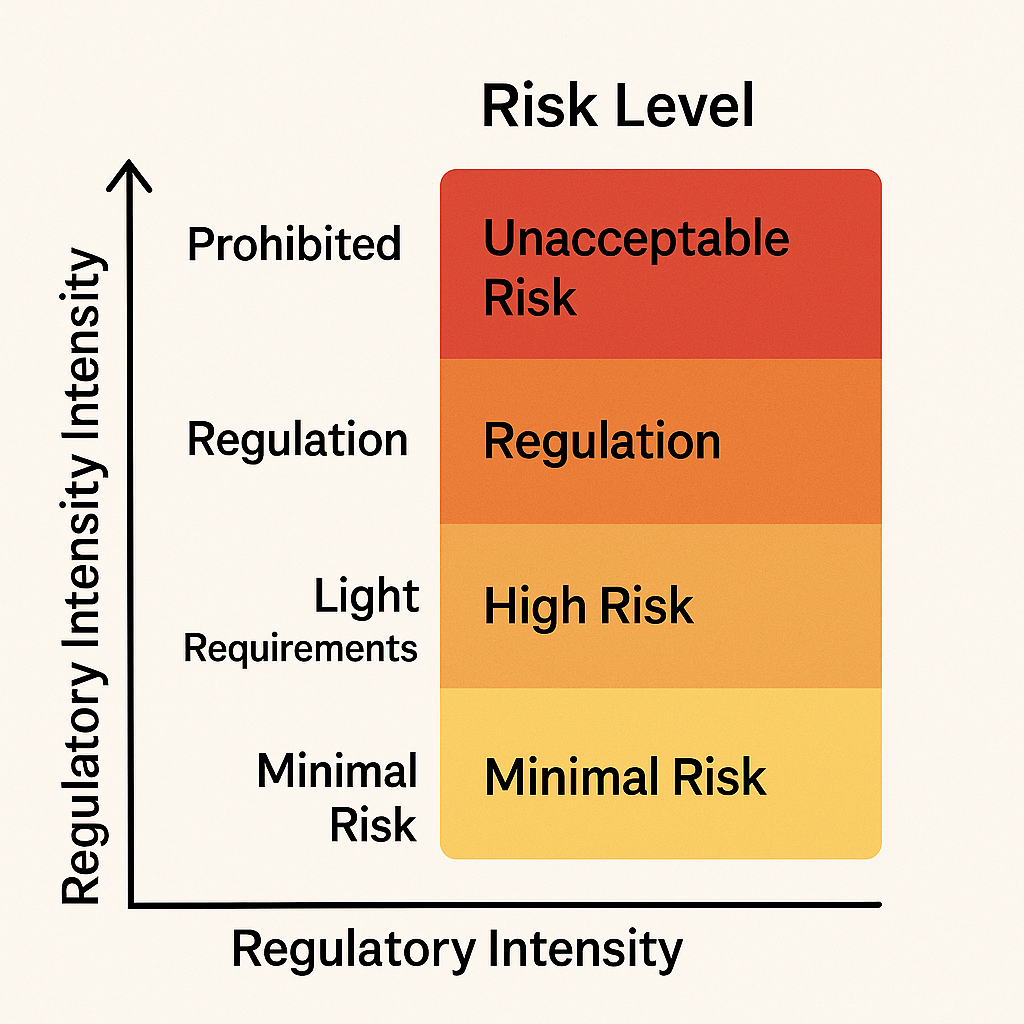

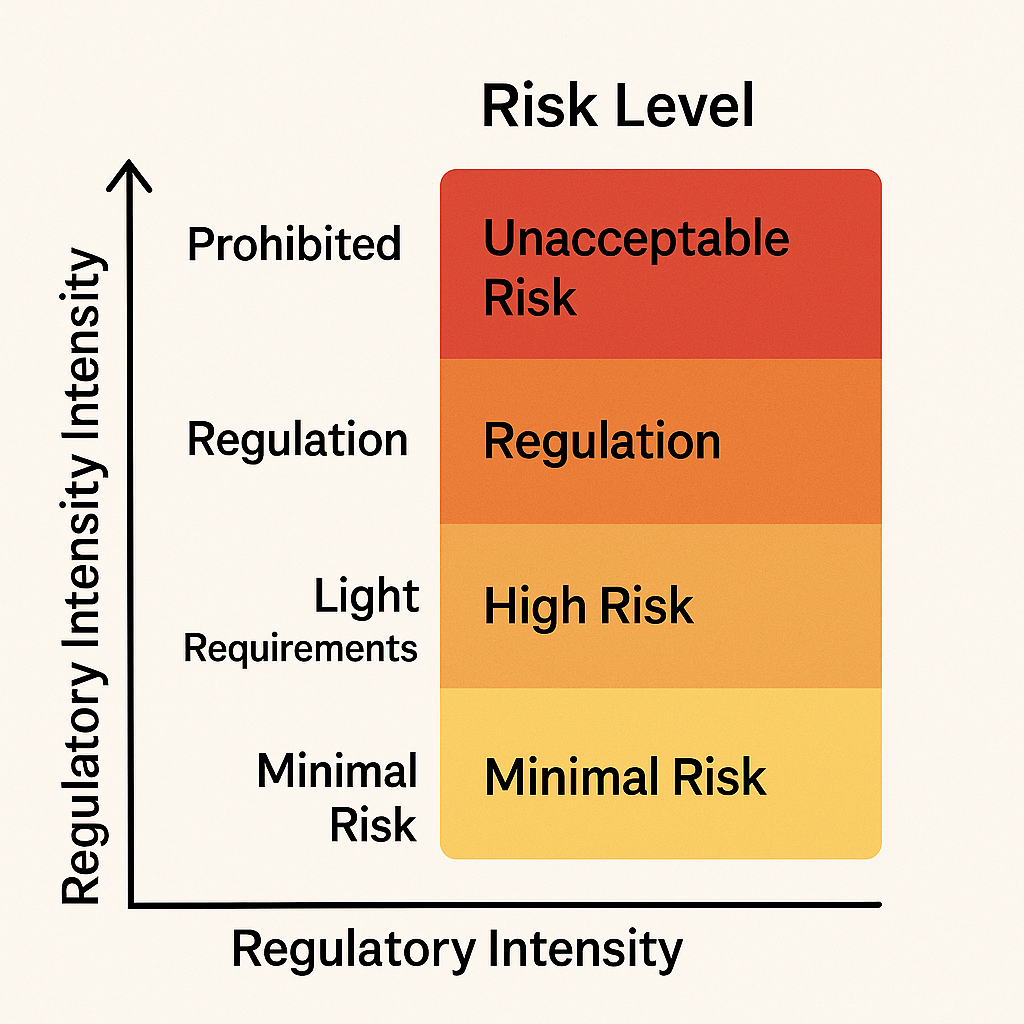

二、风险分级与管理机制

根据AI应用的潜在风险水平,实施差异化的管理策略和合规要求。

- 风险识别与评估:建立标准化的AI风险评估方法论,从技术、伦理、法律、社会等多个维度识别潜在风险。

- 风险分级:

- 不可接受风险 (Unacceptable Risk): 如操纵人类行为造成伤害、社会评分系统等,原则上应禁止。

- 高风险 (High Risk): 如自动驾驶、医疗诊断、关键基础设施管理、司法信贷等领域的AI应用,需遵守严格的强制性要求(如事前合格性评定、严格的测试验证、人类监督、数据质量和透明度要求)。

- 有限风险 (Limited Risk): 如聊天机器人等与人直接交互的AI,需履行特定的透明度义务(告知用户正在与AI互动)。

- 低/最小风险 (Low/Minimal Risk): 如垃圾邮件过滤器、AI游戏等,可依赖自愿性行为准则和一般性产品安全法规。

- 风险缓解与控制:针对不同风险等级,要求采取相应的技术和组织措施进行风险预防、控制和缓解。

- 持续监测与更新:AI风险并非一成不变,需建立对已部署AI系统的持续风险监测、评估和管理更新机制。

图表 3.3: AI伦理项目风险等级与监管强度图

此图表说明不同风险等级的AI应用对应不同的监管强度,是风险管理的核心。

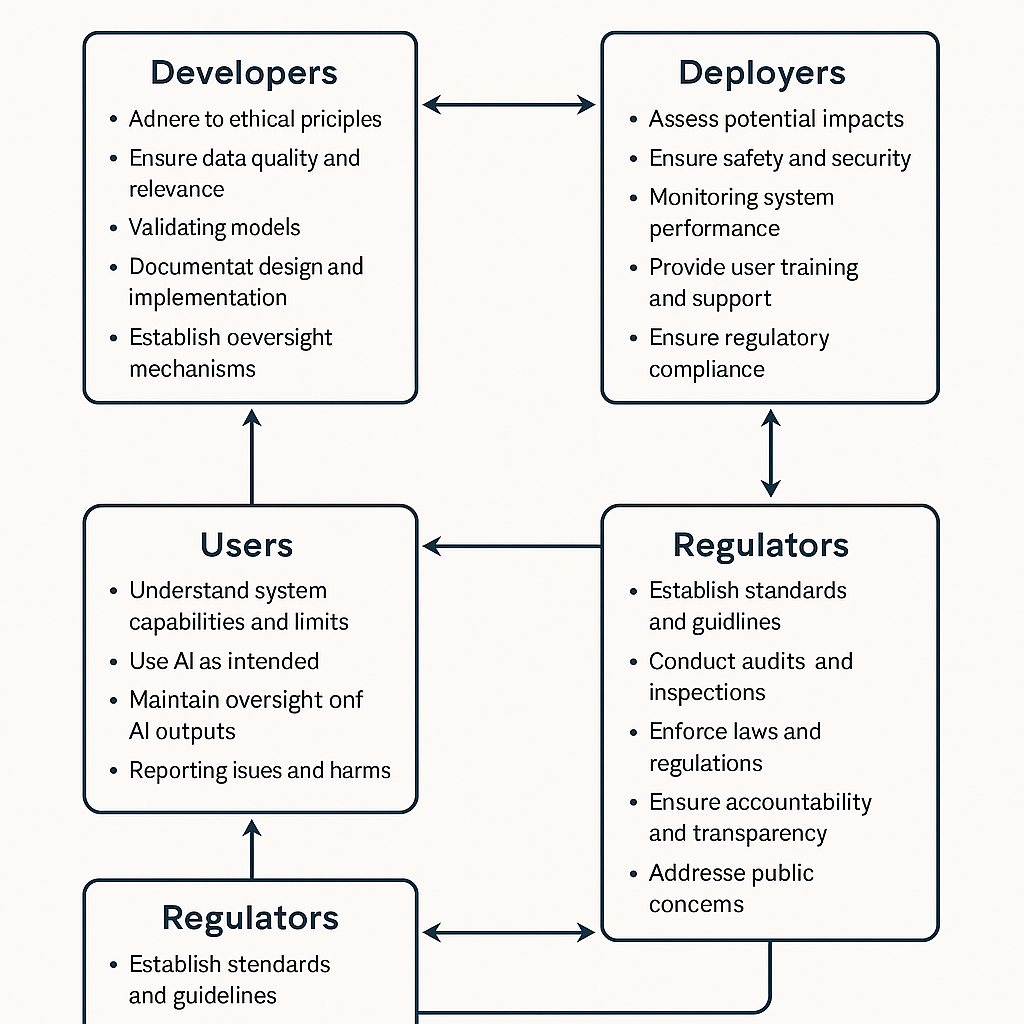

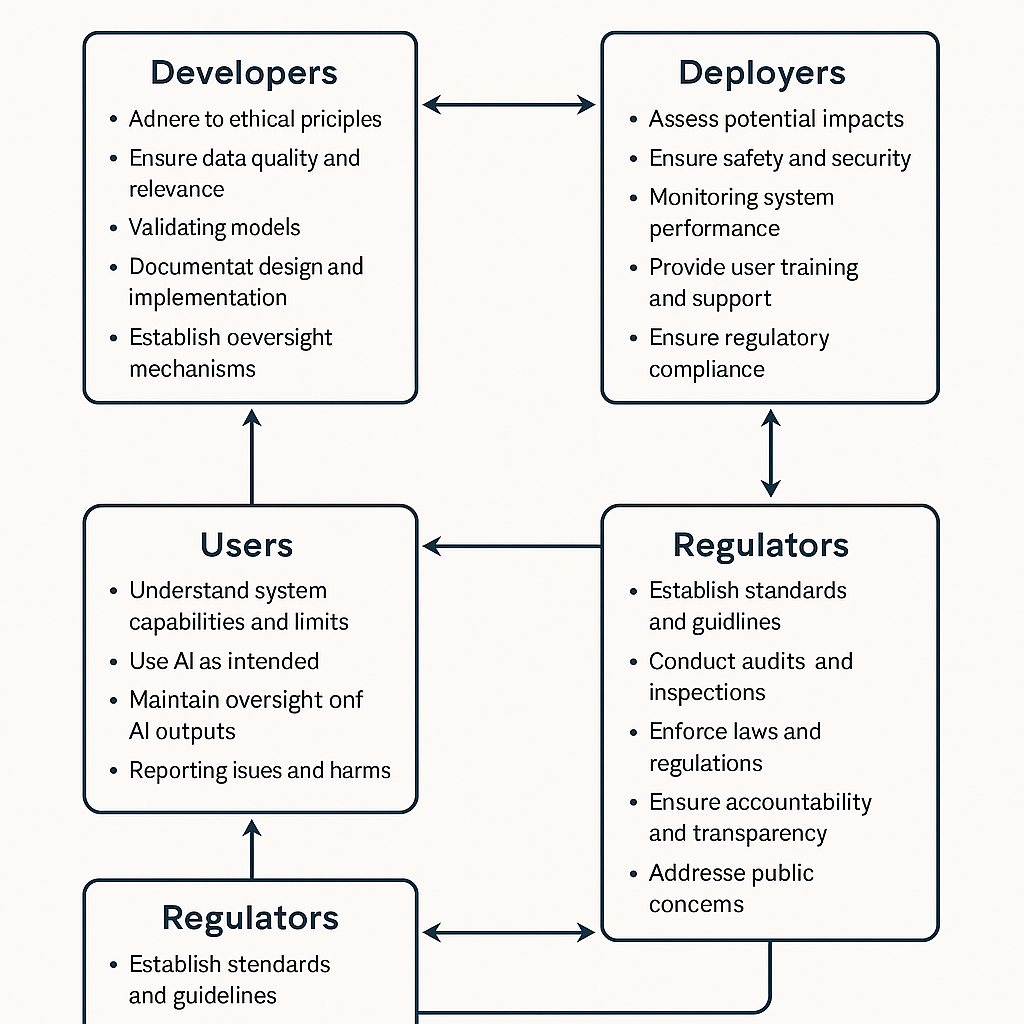

三、多主体责任矩阵体系

明确AI系统生命周期中各参与方(设计者、开发者、部署者、运营者、使用者等)的权利、义务和责任边界。

- 开发者/提供商责任:对AI系统的设计安全、算法公平性、数据质量、模型鲁棒性、可解释性以及充分的风险告知和用户说明承担主要责任。

- 部署者/运营者责任:对AI系统的选择、集成、实际应用场景的风险评估、持续性能监控、用户培训、数据安全保障以及合规运营承担责任。

- 使用者责任:在授权范围内、按照说明和规范合理使用AI系统,并对自身输入和基于AI输出做出的最终决策负责。

- 监管者责任:制定和执行AI相关的法律法规和标准,监督市场行为,保护公众利益,处理争议和投诉。

- 第三方机构责任:如认证机构、测试机构、审计机构,对其提供的服务质量和专业判断负责。

- 责任链条协同:强调各主体间的协同和信息共享,确保责任链条的完整性和可追溯性。

图表 3.4: AI工程伦理相关方责任映射图

此图表旨在清晰展示AI生命周期中不同利益相关者的责任范围。

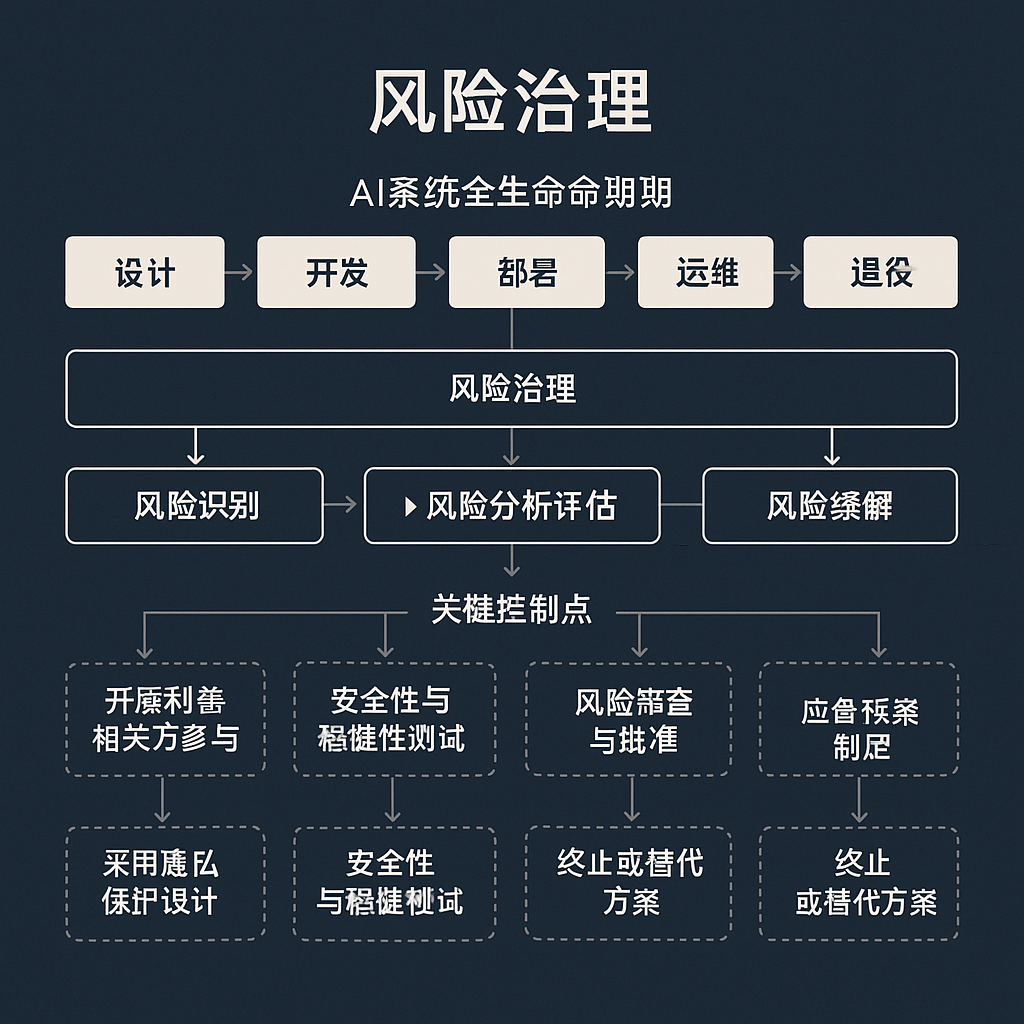

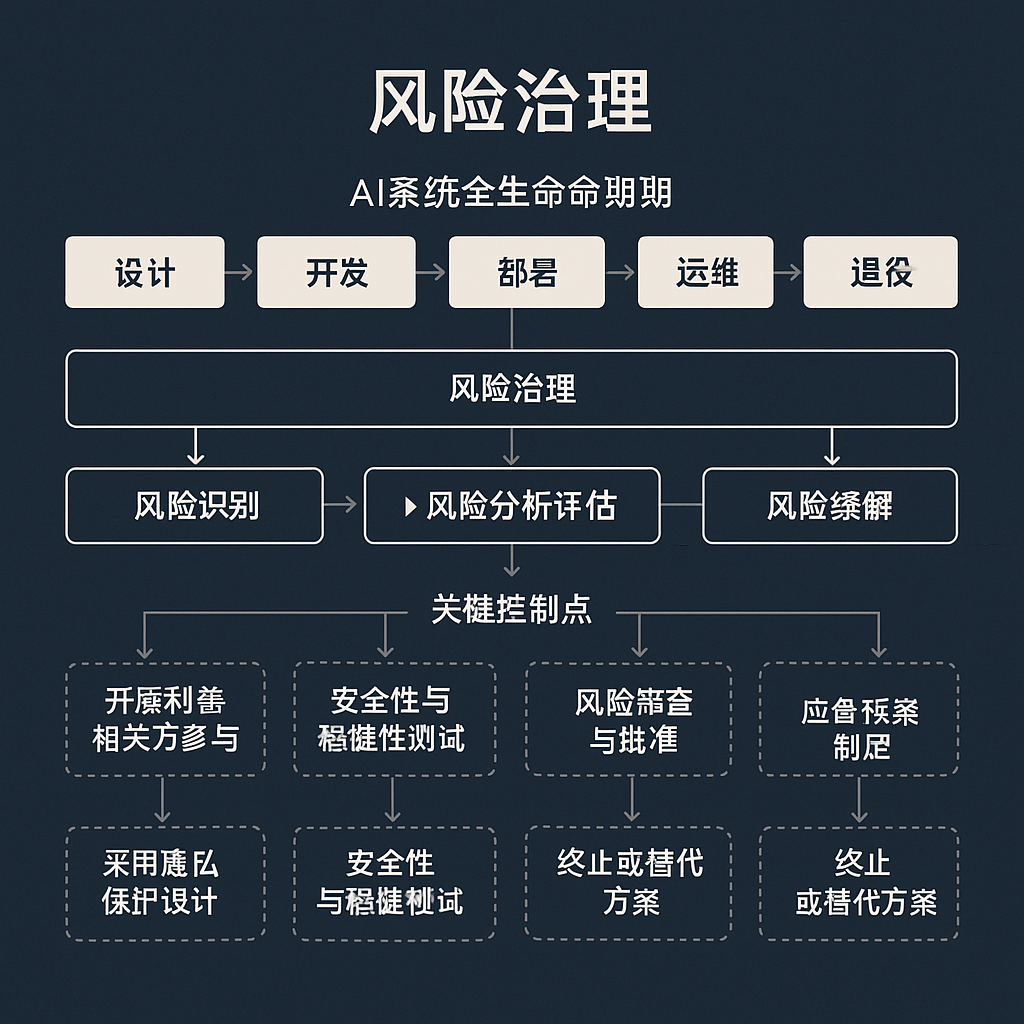

四、全周期治理与协同机制

建立覆盖AI系统从概念到退役全生命周期的治理流程和多方协同治理模式。

- 事前预防 (Ex-ante Governance): 包括伦理设计、影响评估、算法审计、数据合规性审查、标准化测试与认证。

- 事中监测 (In-process Governance): 对运行中的AI系统进行持续性能监控、安全审计、偏见漂移检测、用户反馈收集。

- 事后补救 (Ex-post Governance): 建立清晰的损害报告机制、责任调查程序、争议解决渠道(调解、仲裁、诉讼)和赔偿机制。

- 多方协同治理 (Multi-stakeholder Collaboration): 鼓励政府、行业协会、企业、学术界、技术社区、公民社会组织和公众之间的对话、合作与信息共享,共同参与AI治理标准的制定和实施。

- 适应性治理 (Adaptive Governance): AI治理框架应具备灵活性和适应性,能够根据技术发展、新的风险认知和社会反馈进行动态调整和完善。

图表 3.5: AI系统生命周期风险治理流程图

该流程图展示了AI系统从设计到部署运营各阶段的风险治理环节。

五、技术支撑体系

发展和应用先进技术手段,为AI责任的实现提供技术保障。

- 可解释AI (XAI) 技术:开发和推广能够解释AI模型决策逻辑和依据的技术,提高透明度,辅助责任认定。

- 偏见检测与缓解技术:研究和应用能够识别、量化和减轻训练数据和算法模型中偏见的技术。

- 隐私增强技术 (PETs):如差分隐私、联邦学习、同态加密等,在数据使用过程中保护个人隐私。

- 审计追踪与日志记录技术:确保AI系统的关键操作和决策过程可被记录、存储和审计,为事后追责提供证据。

- 安全可信技术:包括AI模型的鲁棒性测试、对抗性攻击防御、数据安全保障等技术,提升系统整体的可靠性和安全性。

- 标准化与认证技术:开发AI系统和算法的测试、评估和认证技术标准,为合规性评估提供依据。

六、法律政策衔接与完善

推动现有法律体系的适应性调整和新法律规范的制定,为AI责任追究提供法律依据和保障。

- 完善现有法律框架:评估并修订《民法典》(侵权责任编)、《产品质量法》、《消费者权益保护法》、《网络安全法》、《数据安全法》、《个人信息保护法》等相关法律,使其能更好适应AI带来的挑战。

- 探索制定AI专门立法:研究制定专门的《人工智能法》或《人工智能责任法》,系统规定AI的基本伦理原则、风险管理要求、各主体责任、监管机制和法律责任。

- 明确责任认定规则:针对AI特性,细化过错认定标准、因果关系证明规则、举证责任分配(如考虑在高风险场景下的举证责任倒置或减轻)。

- 建立损害赔偿与救济机制:探索设立AI损害赔偿基金、强制责任保险制度等,确保受害者能够获得及时有效的救济。

- 加强监管执法与司法实践:提升监管机构的执法能力和司法机关的专业审判能力,积累AI相关案件的裁判经验。

- 推动国际法律协调:积极参与AI法律与伦理的国际对话和规则制定,推动形成国际共识和协调机制。

)