技术层面深度分析

算法不透明性

深度学习模型的复杂性使得决策过程难以理解和解释

- • 神经网络层次复杂

- • 参数数量庞大

- • 非线性变换难以追踪

- • 缺乏直观解释机制

数据质量问题

训练数据的质量直接影响AI系统的公平性和可靠性

- • 历史数据包含偏见

- • 样本代表性不足

- • 数据标注质量不一

- • 动态数据更新滞后

系统自主性增强

AI系统的自适应和学习能力带来不可预测性

- • 在线学习动态调整

- • 环境交互产生新行为

- • 超出设计预期的决策

- • 人类监督能力有限

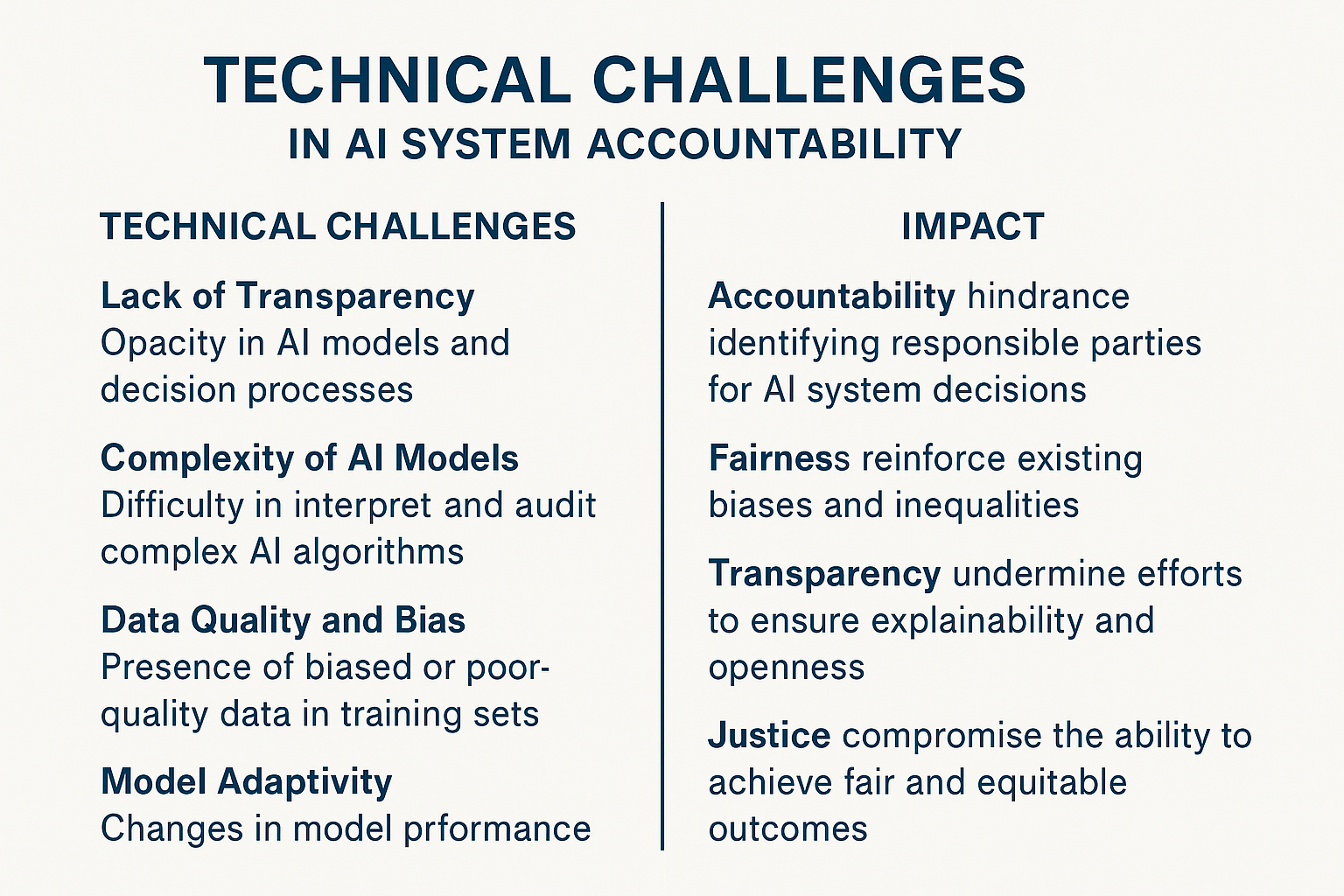

图表 2.2: AI 系统决策责任技术挑战与伦理影响图

此图表展示了AI技术挑战如何对责任归属和伦理产生影响。

技术挑战的量化分析 (示例数据)

的AI决策过程缺乏足够的可解释性,对追责构成挑战。

的关键应用训练数据集中,被发现存在不同程度的偏见问题。

的复杂AI系统行为,在特定情境下可能超出最初设计预期。