综合解决方案框架 (概述)

构建多层次、跨领域协同的治理体系,系统性解决AI系统决策的责任归属与追责难题

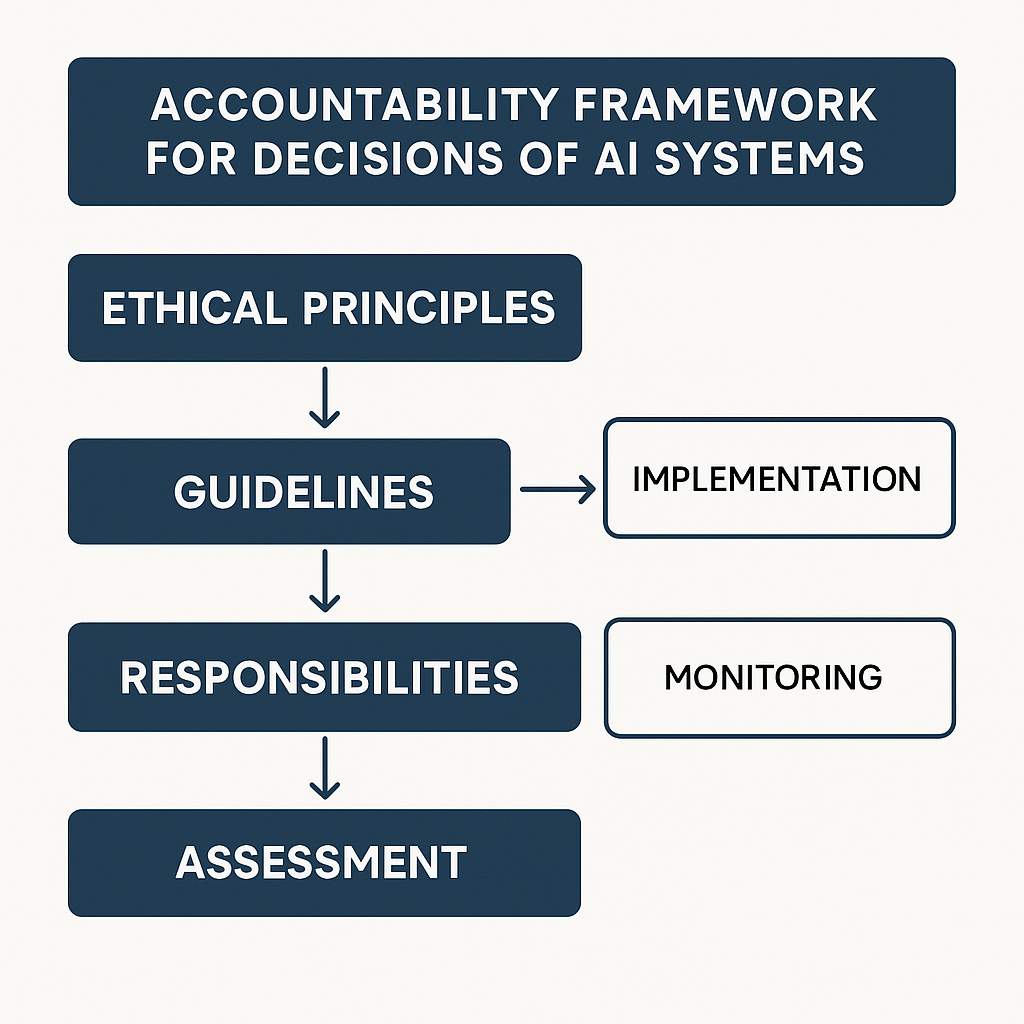

图表 1.1: AI 工程伦理项目概览流程图

此流程图展示了项目研究的整体结构和主要环节。

核心伦理原则体系

建立以人为本、公平公正、可控可信、透明问责等核心原则

- • 以人为本

- • 公平公正与非歧视

- • 可控可信

- • 透明度与可解释性

风险分级管理

依据AI应用风险等级设定差异化合规要求和行为准则

- • 不可接受风险

- • 高风险应用

- • 有限风险

- • 低风险/最小风险

责任矩阵体系

明确AI生命周期中各参与方的权利、义务与责任

- • 开发者责任

- • 运营者责任

- • 用户责任

- • 监管者责任

全周期风险治理

建立涵盖设计、开发、部署、运行全生命周期的风险管控

- • 事前预防

- • 事中监测

- • 事后补救

- • 持续改进

技术支撑体系

构建可解释AI、隐私增强、审计追踪等关键技术基础

- • 可解释AI (XAI)

- • 隐私增强技术

- • 区块链审计

- • 偏见检测工具

法律政策衔接

推动AI责任相关立法和政策制定,完善法律保障

- • AI专门立法

- • 责任认定规则

- • 强制保险制度

- • 国际协调合作